中國(guó)品牌在全球化傳播中,需要理解不同文化背景下不同群體的情感反應(yīng),并采用全球消費(fèi)者可接受的方式講述品牌故事和傳播文化。然而,現(xiàn)有 AI 技術(shù)主要關(guān)注客觀事物解析,缺乏理解人類主觀感受的有效手段。

為了縮小實(shí)際應(yīng)用與技術(shù)之間的差距,明略科技構(gòu)建了大規(guī)模視頻主觀多模態(tài)評(píng)估數(shù)據(jù)集 Video-SME,通過(guò)收集腦電波和眼動(dòng)追蹤數(shù)據(jù),分析不同受試者對(duì)視頻內(nèi)容的認(rèn)知理解程度,并自研超圖多模態(tài)大語(yǔ)言模型(HMLLM),探索人口統(tǒng)計(jì)、視頻元素、腦電圖和眼動(dòng)追蹤指標(biāo)之間的關(guān)聯(lián),彌合了模態(tài)間的語(yǔ)義差距,集成幀間信息以執(zhí)行邏輯推理。實(shí)驗(yàn)結(jié)果證明了 HMLLM 的有效性,為機(jī)器模擬人類主觀感受提供了新的可能性,有助于實(shí)現(xiàn)對(duì)國(guó)外 AI 技術(shù)的超越。

在不久前舉辦的 AICon 全球人工智能開(kāi)發(fā)與應(yīng)用大會(huì)上,明略科技多模態(tài)大模型部門負(fù)責(zé)人趙晨旭帶來(lái)了精彩專題演講“非標(biāo)模態(tài)的多模態(tài)大語(yǔ)言模型如何模擬人類主觀感受”,演講探討了大語(yǔ)言模型缺乏主觀感知能力的問(wèn)題,基于現(xiàn)有評(píng)測(cè)標(biāo)準(zhǔn)的局限性,介紹了 Video-SME 數(shù)據(jù)集,以及超圖多模態(tài)大模型的構(gòu)建和評(píng)測(cè)主觀指標(biāo)的方法。通過(guò) Video-SME 和其他多模態(tài)情感數(shù)據(jù)集的實(shí)驗(yàn)結(jié)果,展示了機(jī)器模擬人類主觀感受的應(yīng)用前景。

內(nèi)容亮點(diǎn):

走進(jìn)多模態(tài)視頻理解全新的未知領(lǐng)域

探索機(jī)器具備主觀感受的全新課題

以下是演講實(shí)錄(經(jīng) InfoQ 進(jìn)行不改變?cè)獾木庉嬚恚?/strong>

我們將依次探討以下幾個(gè)核心議題:首先,分析機(jī)器模擬人類主觀感受的挑戰(zhàn)及其重要價(jià)值。隨后,我們將介紹一個(gè)創(chuàng)新的數(shù)據(jù)集 Video-SME,并展示我們?yōu)榇碎_(kāi)發(fā)的一種新方法——超圖多模態(tài)大模型。此外,我們還將分享在各類主客觀指標(biāo)評(píng)測(cè)中取得的成果。最后,我們會(huì)討論機(jī)器模擬人類主觀感受技術(shù)在實(shí)際應(yīng)用中的多種場(chǎng)景。

|機(jī)器模擬人類主觀感受的難點(diǎn)與價(jià)值

我從學(xué)術(shù)界權(quán)威人士的觀點(diǎn)開(kāi)始講起,引用李飛飛教授今年 5 月的一條 Twitter,她提出,即使參數(shù)眾多的大語(yǔ)言模型,也難以捕捉到人類的主觀感受。這反映了 AI 在視頻內(nèi)容理解上,一直缺乏對(duì)主觀層面的深入探究和準(zhǔn)確的測(cè)量標(biāo)準(zhǔn)。

目前學(xué)術(shù)界對(duì)主觀感知能力的研究主要依賴于側(cè)面觀察,比如通過(guò)人們的情緒表現(xiàn)或媒體傳播的信息來(lái)推斷。這種觀察方式存在局限性,因?yàn)槿藗兛赡軙?huì)故意表現(xiàn)出某種情緒,或者他們的真實(shí)感受與外在表現(xiàn)不符。例如,在音樂(lè)領(lǐng)域,雖然樂(lè)理提供了一種理解情感的方式,但現(xiàn)代人的主觀體驗(yàn)可能與樂(lè)理的傳統(tǒng)解釋大相徑庭。我們的研究工作正是基于這樣的認(rèn)識(shí),試圖從人的主觀視角出發(fā),深入內(nèi)部進(jìn)行采集和觀察,旨在開(kāi)發(fā)出能夠更準(zhǔn)確地模擬和理解人類主觀感受的技術(shù)和方法。

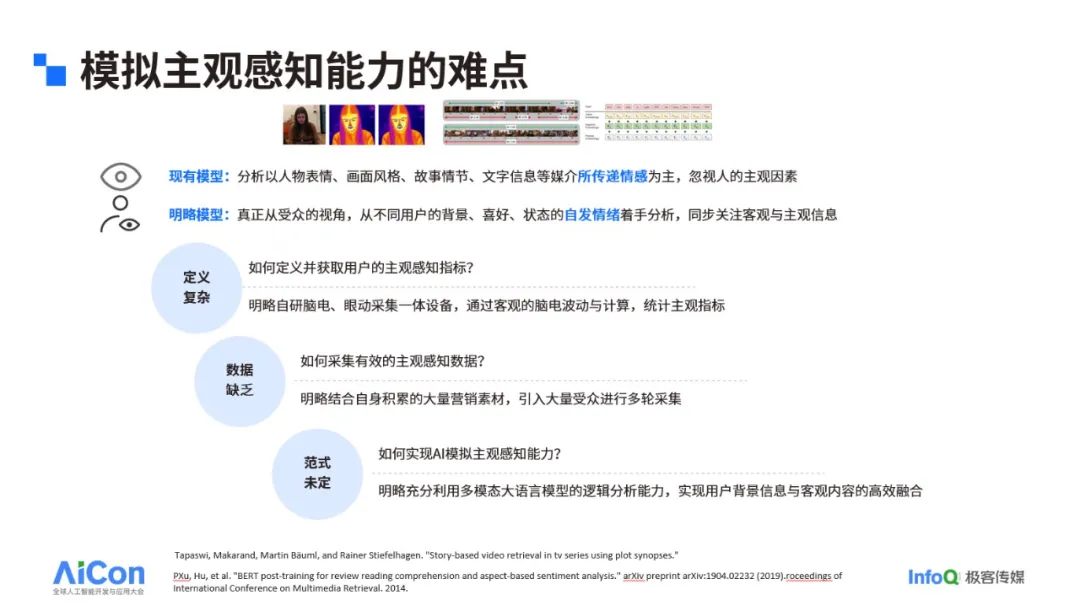

盡管現(xiàn)有的模型主要通過(guò)分析人物表情、畫面風(fēng)格、故事情節(jié)以及文字信息等媒介來(lái)傳遞情感,但這些媒介所傳遞的情感并不總是與人們實(shí)際接收到的情感完全一致。人們的感受會(huì)受到個(gè)人背景、喜好和狀態(tài)的影響,因此,要真正理解人的主觀感受,我們需要從不同用戶的視角出發(fā),分析他們自發(fā)的情緒反應(yīng)。這種分析的挑戰(zhàn)在于,即使是相同的視頻或段子,不同的人群可能會(huì)有不同的反應(yīng)。例如,男性可能覺(jué)得有趣,而女性可能不這樣認(rèn)為;不同年齡段的人,如老人和年輕人,對(duì)同一內(nèi)容的感受也可能截然不同。這種差異性體現(xiàn)了真正的主觀性。

模擬主觀感知能力的難點(diǎn)主要體現(xiàn)在三個(gè)方面:首先是如何定義并獲取用戶的主觀感知指標(biāo),這需要我們深入理解用戶的個(gè)人背景和情感反應(yīng);其次是如何采集有效的主觀感知數(shù)據(jù);最后是如何實(shí)現(xiàn) AI 模擬主觀感知的能力。

|Video-SME 概述

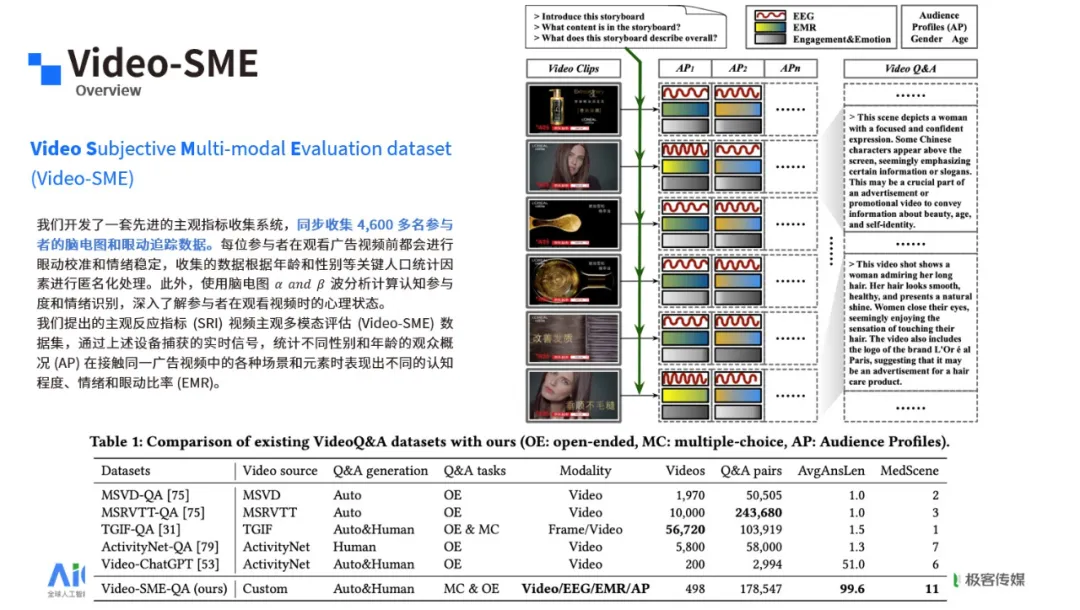

現(xiàn)有的視頻理解數(shù)據(jù)集存在局限性,它們包含的元素通常比較單一,缺乏復(fù)雜性或故事情節(jié),且問(wèn)題設(shè)置往往只涉及顯性的客觀部分,如動(dòng)作識(shí)別或人物身份,并未涉及到主觀感受的維度。為了解決這一問(wèn)題,我們采用了多種傳感器和設(shè)備,記錄受試者在觀看目標(biāo)視頻時(shí)的腦電波和眼動(dòng)數(shù)據(jù)。

廣告視頻內(nèi)容復(fù)雜,分鏡數(shù)量多,Video-SME 數(shù)據(jù)集包含了豐富的模態(tài),在模態(tài)數(shù)量和內(nèi)容復(fù)雜性上具有顯著優(yōu)勢(shì)。此外,我們的評(píng)測(cè)標(biāo)準(zhǔn)不是基于預(yù)設(shè)選項(xiàng),而是描述性的,這有助于更準(zhǔn)確地捕捉和分析主觀感受。

數(shù)據(jù)集的生成流程包括將視頻拆分為多個(gè)分鏡,將語(yǔ)音轉(zhuǎn)換為文本,記錄不同受試者的主觀指標(biāo),如腦電波、認(rèn)知、情緒和眼動(dòng)數(shù)據(jù),并與分鏡內(nèi)容對(duì)應(yīng)。我們還針對(duì)這些主觀指標(biāo)設(shè)計(jì)了問(wèn)答,以評(píng)估受試者的認(rèn)知程度。

我們?cè)跀?shù)據(jù)集中設(shè)計(jì)了兩種任務(wù):主觀任務(wù)和客觀任務(wù)。

主觀任務(wù)的核心是預(yù)測(cè)三個(gè)主觀指標(biāo):認(rèn)知、情緒和眼動(dòng)注視比例。為了量化這些指標(biāo)并使模型能夠模擬它們,我們采取了一種直接的分類方法。具體來(lái)說(shuō),認(rèn)知指標(biāo)的量化是通過(guò)數(shù)值來(lái)判斷的,數(shù)值大于 1 表示有認(rèn)知,小于 1 則表示沒(méi)有認(rèn)知,這一標(biāo)準(zhǔn)參考了認(rèn)知科學(xué)領(lǐng)域的相關(guān)研究。情緒和眼動(dòng)注視比例的分類則是基于數(shù)據(jù)的正態(tài)分布特性。我們根據(jù)數(shù)據(jù)分布的自然劃分,將情緒分為三類:消極、自然和積極。同樣,將眼動(dòng)注視比例也分為三類:完全沒(méi)有注釋、部分注釋和完全注釋。此外,我們進(jìn)一步細(xì)分為兩個(gè)協(xié)議:第一個(gè)協(xié)議 P1 不考慮受眾的個(gè)體差異,而是假設(shè)一個(gè)通用的受眾模型,預(yù)測(cè)通用受眾可能產(chǎn)生的腦電變化;第二個(gè)協(xié)議 P2 則深入考慮了不同受眾的特性,包括性別和年齡等因素,因此 P2 中的問(wèn)題和答案更為豐富和多樣。客觀任務(wù)則涉及到文本生成,但與常規(guī)的選擇題不同,它是一個(gè)開(kāi)放性的問(wèn)題,要求模型生成描述性的答案。

|超圖多模態(tài)大模型概述

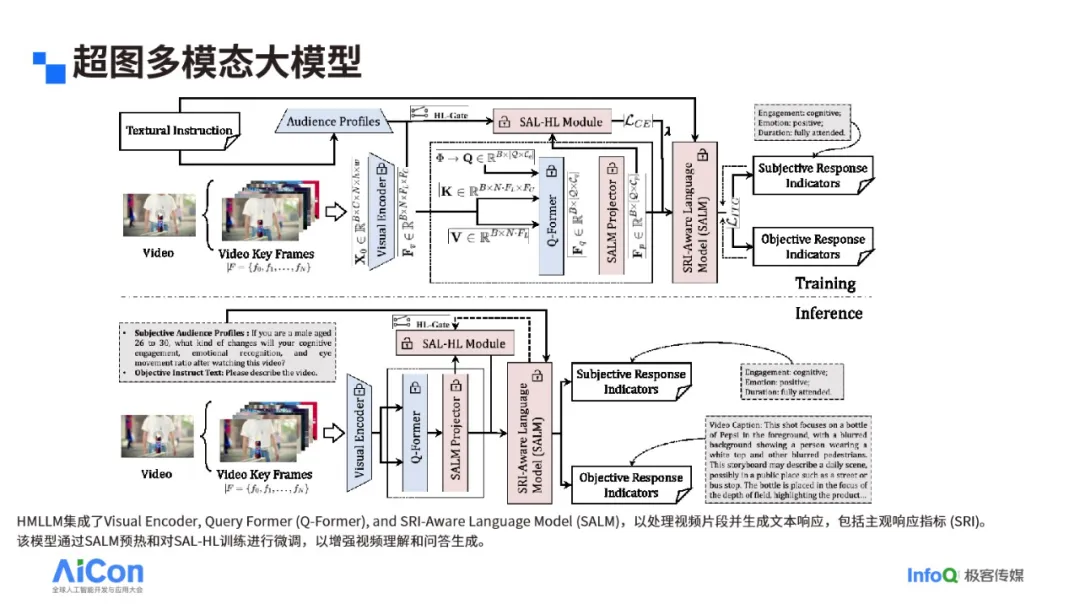

隨著數(shù)據(jù)集的建立,我們著手探索如何有效解決模擬人類主觀感受的挑戰(zhàn)。我們的算法定位為一個(gè)針對(duì)垂直領(lǐng)域的多模態(tài)模型,而非通用基礎(chǔ)模型。在這個(gè)過(guò)程中,我們采用了超圖理論,它允許一條超邊連接多個(gè)點(diǎn),這在視頻理解任務(wù)中尤其有用,因?yàn)橐曨l幀與幀之間的關(guān)系可能跨越較長(zhǎng)時(shí)間維度,涉及多個(gè)幀。

我們的算法架構(gòu)分為訓(xùn)練和推理兩個(gè)部分。在訓(xùn)練階段,我們分為兩個(gè)階段。第一階段專注于客觀部分的訓(xùn)練,即對(duì)視頻內(nèi)容的客觀描述,主要訓(xùn)練語(yǔ)言模型部分。第二階段則專注于主觀部分的訓(xùn)練,涉及超圖學(xué)習(xí)模塊(SAL-HL),該模塊考慮觀眾的性別、年齡等信息,并以視覺(jué)編碼器(如 VIT)作為輸入,以腦電屬性的真實(shí)標(biāo)簽作為監(jiān)督信號(hào)。我們還額外訓(xùn)練了一個(gè)投影器(projector),并通過(guò)設(shè)置權(quán)重λ來(lái)調(diào)整超圖模塊對(duì)整個(gè)網(wǎng)絡(luò)結(jié)構(gòu)的影響。在推理階段,與訓(xùn)練階段相比,觀眾的信息(AAP)直接整合到提示(prompt)中,根據(jù)提問(wèn)的提示直接給出答案。

以一個(gè)經(jīng)典的沃爾沃卡車廣告為例,該廣告通過(guò)尚格云頓在兩輛行駛的卡車間做一字馬來(lái)展示卡車的穩(wěn)定性。我們的模型能夠從兩個(gè)維度輸出描述:客觀描述,如“一個(gè)人在兩輛行駛的卡車間做一字馬”;主觀描述,如“30 至 34 歲男性觀看后的認(rèn)知和情緒反應(yīng)”。模型顯示,男性觀眾能夠很好地理解視頻內(nèi)容,并表現(xiàn)出較高的情緒反應(yīng),這可能是因?yàn)閺V告展示了卡車的穩(wěn)定性和人類的力量感。

我們的模型還能展示不同性別和年齡段觀眾的眼動(dòng)注釋區(qū)域。通過(guò)熱力圖反映了觀眾在觀看視頻時(shí)的真實(shí)注意力分布,顯示出不同人群對(duì)同一畫面內(nèi)容的關(guān)注點(diǎn)存在差異。例如,女性可能更關(guān)注男性人物身上的文本信息,而男性可能更關(guān)注產(chǎn)品本身,如卡車或可樂(lè)。這些發(fā)現(xiàn)為我們提供了深入理解觀眾主觀感受的寶貴視角。

|主客觀指標(biāo)評(píng)測(cè)結(jié)果

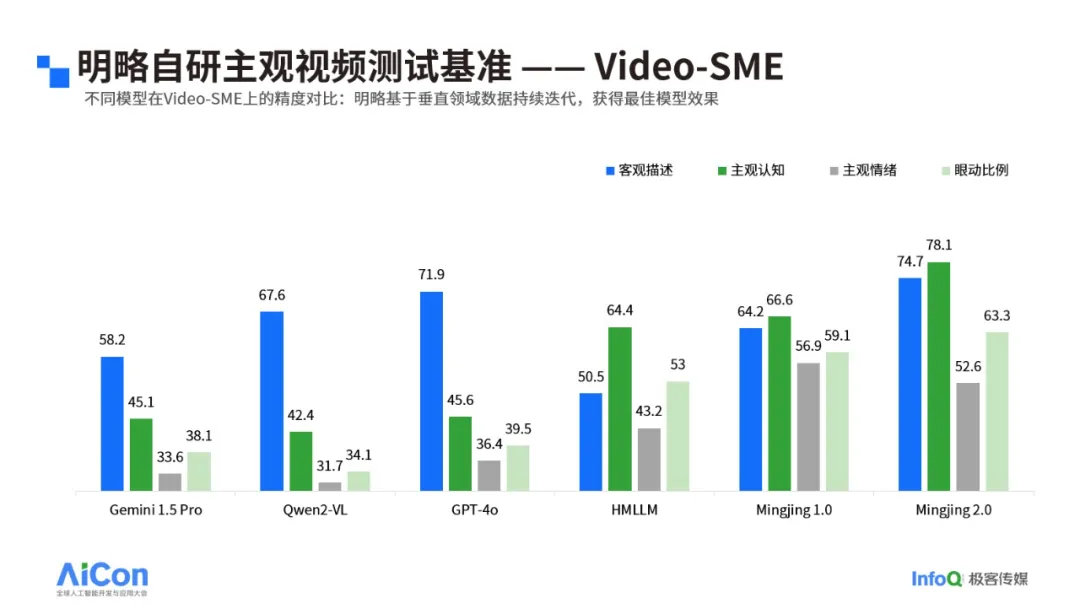

Video-SME 數(shù)據(jù)集通過(guò)幾個(gè)關(guān)鍵指標(biāo)來(lái)衡量模型的性能,其中包括客觀描述和三種腦電反應(yīng):主觀認(rèn)知、主觀情緒和眼動(dòng)比例。在這些特殊任務(wù)上,商用模型如 Gimma 1.5、GPT-4o 在主觀指標(biāo)預(yù)測(cè)上的表現(xiàn)并不理想。經(jīng)過(guò)訓(xùn)練和微調(diào),我們的方法在這些任務(wù)上展現(xiàn)出了更好的效果。在 Video-MME 數(shù)據(jù)集上,由于主要涉及客觀層面的理解,且形式為選擇題,商用模型的表現(xiàn)普遍較好。在其他的公開(kāi)數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果同樣顯示了我們模型的潛力。例如,在 VideoEmotion-8 數(shù)據(jù)集上,僅使用視覺(jué)模態(tài),我們的模型就達(dá)到了 59.8% 的準(zhǔn)確率;在 Video Conversation 基準(zhǔn)測(cè)試中,我們的模型在多種任務(wù)上達(dá)到了 SOTA(State of the Art)。

我們還對(duì)超圖模塊進(jìn)行了消融學(xué)習(xí)實(shí)驗(yàn),發(fā)現(xiàn)當(dāng)權(quán)重λ設(shè)置為 0.1 時(shí),模型表現(xiàn)最佳。這表明超圖模塊在適當(dāng)權(quán)重下能顯著提升模型性能,但過(guò)高的權(quán)重可能會(huì)帶來(lái)副作用。

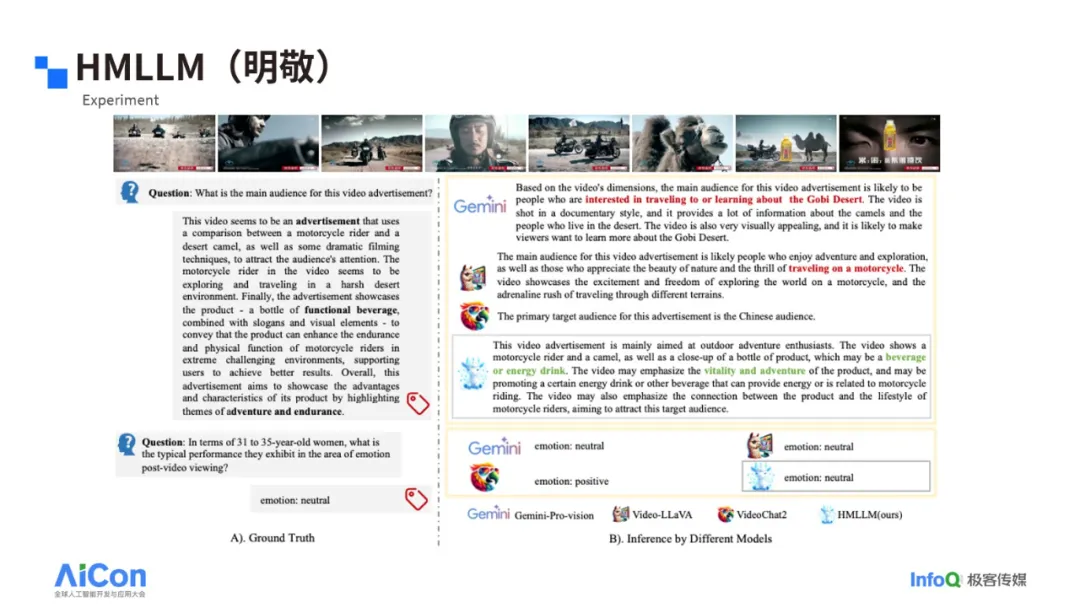

在定性分析中,比如識(shí)別一種抹茶味巧克力派的視頻中,我們的模型能夠準(zhǔn)確指出這是一種零食,且可能受到年輕人或兒童的歡迎,而其他開(kāi)源模型則誤判為冰激凌。在分析東鵬特飲的廣告時(shí),我們的模型能夠識(shí)別出這是一種運(yùn)動(dòng)飲料,并與運(yùn)動(dòng)力量和冒險(xiǎn)聯(lián)系起來(lái),而其他模型如 Gemini 則錯(cuò)誤地將其歸類為旅行或冒險(xiǎn)。

|機(jī)器模擬人類主觀感受的應(yīng)用場(chǎng)景

我們開(kāi)發(fā)了一款名為 Adeff 的產(chǎn)品,它能夠從主觀和客觀兩個(gè)維度對(duì)廣告內(nèi)容進(jìn)行評(píng)測(cè)。以 YouTube 上蘭蔻的廣告為例,Adeff 可以提供整個(gè)視頻的客觀描述,對(duì)視頻分鏡進(jìn)行詳細(xì)分析,并給出每個(gè)分鏡的主觀指標(biāo),如腦電效果、情緒和注視比例。Adeff 的應(yīng)用不僅限于單一廣告。通過(guò)對(duì)比不同受眾群體的反應(yīng),如普通受眾與特定年齡和性別的受眾,Adeff 能夠展示廣告對(duì)不同人群的吸引力差異。這種能力對(duì)于廣告創(chuàng)意的評(píng)測(cè)至關(guān)重要,可以幫助品牌主理解色彩、角度、情緒等廣告元素如何影響受眾的主觀感受。

利用機(jī)器模擬人類主觀感受進(jìn)行廣告創(chuàng)意評(píng)測(cè),可以顯著降低成本。傳統(tǒng)上,進(jìn)行全面的創(chuàng)意評(píng)測(cè)需要大量人力和設(shè)備,而 AI 的介入使這一過(guò)程更加經(jīng)濟(jì)高效。AI 模型可以通過(guò)真人測(cè)量數(shù)據(jù)進(jìn)行訓(xùn)練和校正,提供快速、全面的評(píng)測(cè),降低投放風(fēng)險(xiǎn),縮短測(cè)試周期,并實(shí)現(xiàn)規(guī)模化測(cè)量。

我們的研究不僅在理論上有所突破,而且在實(shí)踐中也取得了成功。我們的產(chǎn)品能夠提前預(yù)測(cè)廣告效果,幫助客戶優(yōu)化廣告內(nèi)容,避免無(wú)效投放。例如,通過(guò)分析廣告母片和街片的分鏡,我們可以識(shí)別出哪些分鏡更受歡迎,從而指導(dǎo)廣告剪輯和投放策略。

我們的工作得到了科技部科技創(chuàng)新 2030 新一代人工智能重大項(xiàng)目的支持,并在 ACMMM 2024 會(huì)議上獲得了最佳論文提名。我們的論文和項(xiàng)目代碼已經(jīng)公開(kāi),數(shù)據(jù)集也對(duì)外開(kāi)放,供學(xué)術(shù)界和工業(yè)界使用。感興趣的人士可以通過(guò)論文鏈接和 GitHub 項(xiàng)目鏈接進(jìn)一步了解:

論文鏈接:https://dl.acm.org/doi/10.1145/3664647.3680810

GitHub 地址:https://github.com/mininglamp-MLLM/HMLLM

|總? ?結(jié)

機(jī)器模擬人的主觀感受具有重大意義。這不僅是技術(shù)進(jìn)步的體現(xiàn),也是我們理解人類認(rèn)知和情感的重要途徑。

機(jī)器模擬人的主觀感受可能是機(jī)器產(chǎn)生自我意識(shí)的開(kāi)端。Google 員工關(guān)于模型自我意識(shí)的報(bào)道激發(fā)了人們對(duì)機(jī)器意識(shí)可能性的廣泛思考。

機(jī)器已經(jīng)具備有效手段來(lái)模擬人類的主觀感受。通過(guò)先進(jìn)的算法和多模態(tài)數(shù)據(jù)集,機(jī)器能夠分析和理解人類的情感和認(rèn)知反應(yīng)。

多模態(tài)大語(yǔ)言模型的范式仍有廣闊的發(fā)展空間。隨著大模型的不斷優(yōu)化和擴(kuò)展,我們可以期待 AI 在模擬人類主觀感受方面將取得更多的突破,這將為人工智能的發(fā)展開(kāi)辟新的道路。

數(shù)字廣告測(cè)量及驗(yàn)證

數(shù)字廣告測(cè)量及驗(yàn)證 戶外廣告監(jiān)播&測(cè)量

戶外廣告監(jiān)播&測(cè)量 一站式社媒營(yíng)銷監(jiān)測(cè)與洞察平臺(tái)

一站式社媒營(yíng)銷監(jiān)測(cè)與洞察平臺(tái) 一站式社媒營(yíng)銷投資優(yōu)化管理平臺(tái)

一站式社媒營(yíng)銷投資優(yōu)化管理平臺(tái) 以消費(fèi)者服務(wù)體驗(yàn)為核心的企業(yè)客戶數(shù)據(jù)管理平臺(tái)

以消費(fèi)者服務(wù)體驗(yàn)為核心的企業(yè)客戶數(shù)據(jù)管理平臺(tái) 集全域媒體計(jì)劃管理、數(shù)據(jù)監(jiān)測(cè)分析等綜合功能于一體

集全域媒體計(jì)劃管理、數(shù)據(jù)監(jiān)測(cè)分析等綜合功能于一體 AI 驅(qū)動(dòng)的廣告前測(cè)平臺(tái)

AI 驅(qū)動(dòng)的廣告前測(cè)平臺(tái) 輕量化、一體化、結(jié)合AI CO-Pilot的智能投放系統(tǒng)

輕量化、一體化、結(jié)合AI CO-Pilot的智能投放系統(tǒng) 以客戶為中心,集新模式與高質(zhì)量服務(wù)為一體

以客戶為中心,集新模式與高質(zhì)量服務(wù)為一體 助力零售行業(yè)打造覆蓋客戶全生命周期的數(shù)值化運(yùn)營(yíng)體系

助力零售行業(yè)打造覆蓋客戶全生命周期的數(shù)值化運(yùn)營(yíng)體系 圍繞家具行業(yè)消費(fèi)者連接的全流程, 從引流獲客,導(dǎo)購(gòu),設(shè)計(jì)賦能

圍繞家具行業(yè)消費(fèi)者連接的全流程, 從引流獲客,導(dǎo)購(gòu),設(shè)計(jì)賦能 從品牌商家的核心訴求出發(fā),重新定 義“人貨物,構(gòu)建以大數(shù)據(jù)驅(qū)動(dòng)的….

從品牌商家的核心訴求出發(fā),重新定 義“人貨物,構(gòu)建以大數(shù)據(jù)驅(qū)動(dòng)的…. 幫助家電3C企業(yè)構(gòu)建公域私域聯(lián)動(dòng)的 流量

幫助家電3C企業(yè)構(gòu)建公域私域聯(lián)動(dòng)的 流量 母嬰消費(fèi)者數(shù)據(jù)全鏈路管理,發(fā)現(xiàn)消費(fèi)者全鏈路路徑路徑?jīng)Q策點(diǎn),沉淀母嬰行業(yè)全鏈路消費(fèi)數(shù)據(jù)

母嬰消費(fèi)者數(shù)據(jù)全鏈路管理,發(fā)現(xiàn)消費(fèi)者全鏈路路徑路徑?jīng)Q策點(diǎn),沉淀母嬰行業(yè)全鏈路消費(fèi)數(shù)據(jù)

題下篇.png)

題上篇.png)

資訊宣傳微信公眾號(hào)首圖公眾號(hào)次圖-2.jpg)